Zusammenfassung

Verfasst von Marcus A. Volz. Der Google Knowledge Graph ist nur so verlässlich wie die Quellen, aus denen er gespeist wird. Wikipedia, Wikidata und DBpedia bilden das Fundament: Sie liefern Sprache, Struktur und Logik – die unsichtbare Infrastruktur, auf der Googles Verständnis der Welt beruht. Dieser Artikel zeigt, wie diese drei Systeme zusammenspielen und warum semantische Konsistenz über alle Ebenen hinweg zur Grundlage digitaler Sichtbarkeit geworden ist.

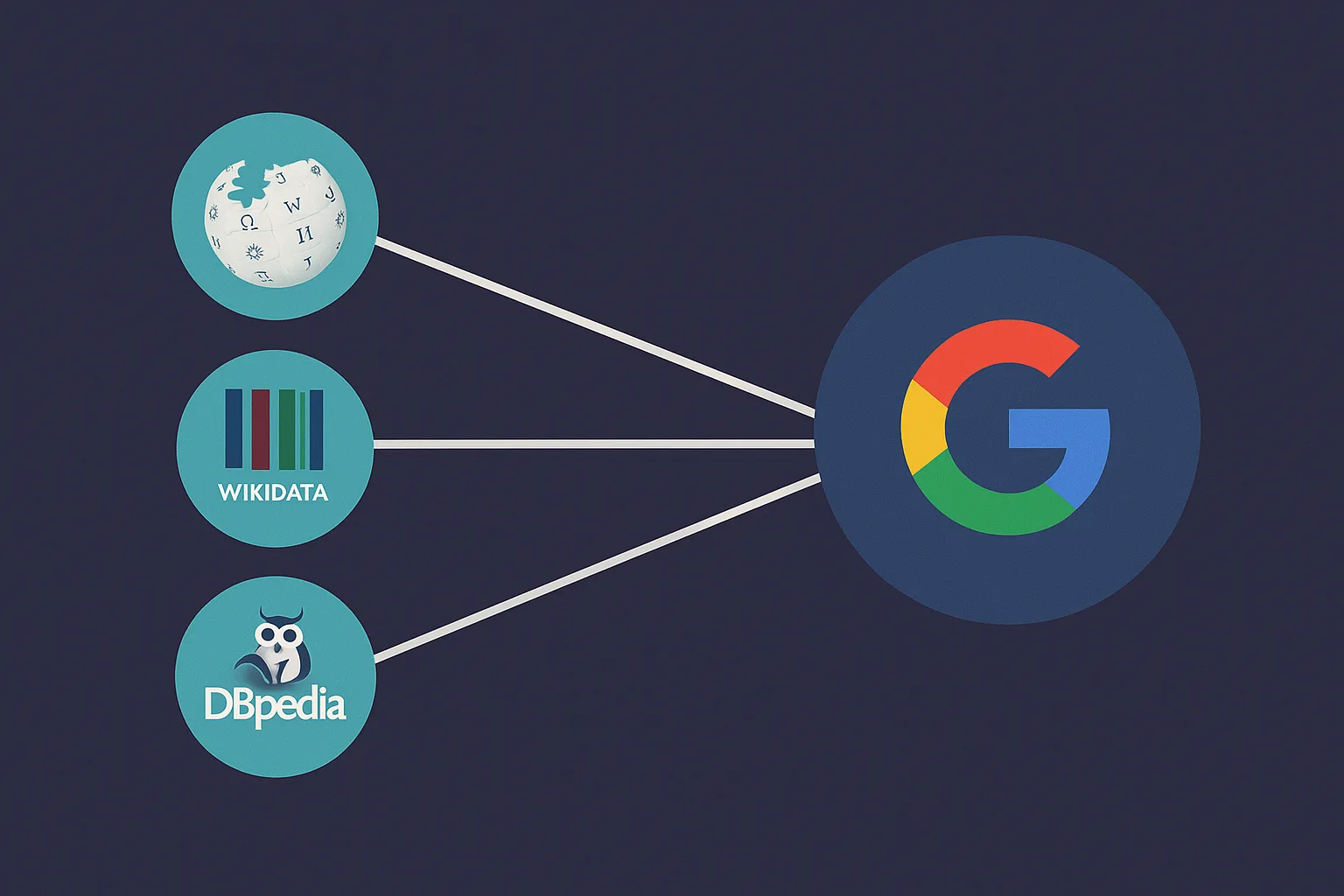

Datenquellen des Google Knowledge Graph – Wikipedia, Wikidata und DBpedia

Einleitung – Wissen braucht Herkunft

Der Google Knowledge Graph ist nur so verlässlich wie die Quellen, aus denen er gespeist wird.

Damit Suchmaschinen Wissen korrekt verknüpfen können, benötigen sie strukturierte, überprüfbare und fortlaufend aktualisierte Daten.

Drei Systeme bilden dafür das Fundament: Wikipedia, Wikidata und DBpedia.

Sie liefern Sprache, Struktur und Logik – und sind damit die unsichtbare Infrastruktur, auf der Googles Verständnis der Welt beruht.

Jede dieser Quellen erfüllt eine eigene Funktion:

Wikipedia erzählt, Wikidata ordnet, DBpedia verbindet.

Zusammen ermöglichen sie, dass Maschinen Fakten erkennen, Beziehungen berechnen und Bedeutung zuordnen können.

1. Von Text zu Struktur – Der Übergang zur maschinenlesbaren Welt

Klassische Enzyklopädien wurden für Menschen geschrieben. Sie erklären Zusammenhänge in Sprache, nicht in Daten.

Doch maschinelle Systeme benötigen eine andere Form: Wissen muss formalisiert sein – in klaren Einheiten, eindeutigen Bezügen und maschinenverständlicher Syntax.

Dieser Wandel, vom erzählten Wissen zur strukturierten Information, ist der Kern der semantischen Wende im Web.

Wikipedia, Wikidata und DBpedia sind die drei aufeinander abgestimmten Stufen dieses Übergangs.

2. Wikipedia – Das narrative Fundament

Wikipedia ist die sprachliche Ausgangsschicht des Wissens.

Sie liefert die Beschreibungen, Definitionen und Kontexte, aus denen Google erkennt, welche Entitäten überhaupt existieren.

Wenn ein neuer Artikel über eine Person, Stadt oder Theorie entsteht, dient er als semantischer Hinweis: Diese Entität ist relevant, eindeutig und verifiziert.

Googles Systeme extrahieren aus Wikipedia unter anderem:

- die ersten Absätze (Definition und Klassenzugehörigkeit)

- interne Links (semantische Nachbarschaften)

- Quellenangaben (Vertrauenssignale)

- Kategorien (themenbezogene Cluster)

Wikipedia ist damit nicht strukturiert, aber semantisch vorbereitet: Sie enthält alle sprachlichen Muster, die später von maschinellen Systemen in formale Relationen übersetzt werden.

Beispiel – Galileo Galilei:

Im Satz „Galileo Galilei war ein italienischer Physiker und Astronom" erkennt Google mehrere Entitäten (Person, Land, Berufsbezeichnungen) und deren Beziehung.

Wikidata und DBpedia übernehmen diese Informationen anschließend in strukturierter Form.

3. Wikidata – Struktur und Eindeutigkeit

Wikidata ist das semantische Gegenstück zu Wikipedia.

Während Wikipedia in Sprache arbeitet, verwendet Wikidata Tripel – also Datensätze in der Form Subjekt – Prädikat – Objekt.

Jede Entität besitzt eine Q-ID (z. B. Q937 für Galileo Galilei). Diese Kennung ist universell, sprachunabhängig und maschinenlesbar.

Beispiel – Galileo Galilei in Wikidata:

Q937 → educated at → Q230533 (Universität Pisa)Wikidata unterscheidet dabei drei Ebenen:

Property (Eigenschaft): beschreibt die Art der Beziehung, z. B. „Geburtsort".

Qualifier (Einschränkung): liefert Kontext, z. B. Zeitraum oder Quelle.

Reference (Beleg): verweist auf die Quelle der Information.

Dadurch entsteht ein Netz, das präziser und konsistenter ist als die narrative Struktur der Wikipedia.

Google nutzt Wikidata, um:

- Entitäten eindeutig zu identifizieren

- Fakten zu validieren

- Mehrdeutigkeiten aufzulösen

- Sprachversionen zu harmonisieren

Für semantische SEO ist Wikidata der Ort, an dem digitale Identität technisch verankert wird. Ein korrekter Eintrag mit klaren Eigenschaften, passenden Aliasnamen und stabilen Quellen stärkt die Sichtbarkeit einer Entität im gesamten Knowledge Graph.

4. DBpedia – Die Brücke ins semantische Web

DBpedia entstand, bevor Wikidata existierte.

Sie wurde entwickelt, um die Inhalte der Wikipedia automatisch in das Format des Resource Description Framework (RDF) zu überführen – also in eine Sprache, die Maschinen verstehen.

Jede Wikipedia-Seite wird dabei in eine eindeutige URI (Uniform Resource Identifier) übersetzt, etwa:

http://dbpedia.org/resource/Galileo_GalileiZu jeder Ressource werden Attribute abgeleitet:

Beispiel – Galileo Galilei in DBpedia:

dbp:birthPlace → dbpedia:Pisa

dbp:field → dbpedia:PhysicsDBpedia machte erstmals möglich, dass Wissenseinheiten unterschiedlicher Herkunft verlinkt werden können – ein Grundpfeiler des „Linked Open Data"-Konzepts.

Aktuelle Rolle von DBpedia

Google nutzte DBpedia vor allem in den frühen Jahren des Knowledge Graph, um Relationen zu erkennen und externe Datenbanken miteinander zu verbinden.

Heute dient DBpedia vor allem als Brückentechnologie: Sie verknüpft Wikidata mit anderen offenen Datenquellen (z. B. GeoNames, MusicBrainz, Freebase-Archiv) und stellt eine standardisierte semantische Schnittstelle bereit.

Wichtig: Während Wikidata DBpedia weitgehend abgelöst hat, bleibt DBpedia relevant für die Vernetzung mit Legacy-Systemen und spezialisierten Fachdatenbanken.

5. Zusammenspiel – Drei Ebenen, ein System

Die drei Systeme ergänzen sich, sie konkurrieren nicht.

| Ebene | Quelle | Format | Hauptfunktion |

|---|---|---|---|

| Sprachlich | Wikipedia | Text | Kontext, Definition, Erzählung |

| Strukturell | Wikidata | Datenbank (Tripel) | Fakten, Entitäten, Relationen |

| Semantisch-vernetzt | DBpedia | RDF / URI | Integration in das semantische Web |

Google nutzt sie gemeinsam:

Wikipedia liefert sprachliche Hinweise auf neue oder relevante Entitäten,

Wikidata bestätigt die Struktur und Bedeutung dieser Entitäten,

DBpedia sorgt für Interoperabilität zwischen unterschiedlichen Datenquellen.

Das Ergebnis ist ein mehrschichtiges semantisches System, das gleichzeitig erzählerisch, logisch und technisch funktioniert.

6. Wie Google diese Daten zusammenführt

Der Prozess der Datenfusion verläuft in mehreren Schritten:

Matching

Eine Wikipedia-Seite wird ihrer Wikidata-Q-ID zugeordnet.

Verknüpfung

DBpedia erzeugt eine korrespondierende URI, die alle Versionen verbindet.

Validierung

Mehrere Quellen mit identischen Aussagen erhöhen das Vertrauen in eine Information.

Versionierung

Änderungen in Wikidata werden laufend übernommen, ältere Aussagen bleiben dokumentiert.

Integration

Bestätigte Tripel gelangen in den Knowledge Graph, wo sie maschinell gewichtet werden.

So entsteht eine mehrdimensionale Absicherung:

Text liefert Kontext, Daten liefern Präzision, RDF liefert Verknüpfung.

7. Bedeutung für semantische SEO

Wer verstehen will, wie Google Entitäten bewertet, muss verstehen, woher sie stammen.

Wikipedia, Wikidata und DBpedia sind nicht nur Datenquellen – sie sind Reputationsschichten.

Wer in ihnen korrekt und konsistent vertreten ist, besitzt für Suchmaschinen eine stabile Identität.

Praktische Implikationen:

Konsistenz: Name, Ort, Gründungsjahr und andere Attribute sollten auf allen Kanälen übereinstimmen.

sameAs-Verknüpfungen: JSON-LD-Markup sollte auf die offiziellen Wikidata- oder DBpedia-URIs verweisen.

Beispiel für sameAs-Markup:

"sameAs": [

"https://www.wikidata.org/wiki/Q937",

"http://dbpedia.org/resource/Galileo_Galilei"

]Referenzen: Wenn möglich, sollte eine Website in Wikidata als Quelle oder „official website" eingetragen sein.

Sprache & Kontext: Wikipedia ist sprachsensitiv. Unterschiedliche Sprachversionen können unterschiedliche Entitäten-Kontexte erzeugen – daher ist Mehrsprachigkeit ein Qualitätsmerkmal.

Ein konsistenter Auftritt in diesen Datenbanken erhöht die Wahrscheinlichkeit, im Knowledge Graph als kanonische Quelle anerkannt zu werden.

8. Risiken und Qualitätsprobleme

Jedes dieser Systeme ist offen und damit anfällig für Fehler:

Wikipedia: Texte können fehlerhaft, tendenziös oder vandalisiert sein.

Wikidata: unvollständige Properties oder falsche Verknüpfungen durch unzureichende Quellen.

DBpedia: extrahiert Daten maschinell, wodurch Syntaxfehler oder alte Informationen erhalten bleiben.

Google begegnet diesen Problemen durch Redundanz:

Nur Aussagen, die in mehreren, unabhängigen Quellen übereinstimmen, werden im Knowledge Graph übernommen.

Fakten mit geringer Bestätigung bleiben unsichtbar oder werden als unsicher markiert.

9. Die Rolle von Sprache und Aktualität

Ein oft unterschätzter Faktor ist die Sprachvariante.

Der Knowledge Graph gleicht Informationen nicht nur inhaltlich, sondern auch sprachlich ab.

Eine Entität kann in unterschiedlichen Sprachversionen verschiedene Detailgrade besitzen.

Beispiel:

Der deutsche Wikidata-Eintrag zu „Johann Sebastian Bach" enthält oft mehr Musik-Properties als der englische.

Für semantische SEO bedeutet das:

Sprachspezifische Pflege in Wikidata und Wikipedia kann dazu führen, dass eine Entität regional stärker sichtbar wird.

Google nutzt jeweils die lokal vertrauenswürdigste Sprachversion als primäre Quelle für den Knowledge Graph eines Landes.

Praktischer Tipp: Wenn du in Deutschland, Österreich oder der Schweiz sichtbar sein willst, sollten die deutschen Wikipedia- und Wikidata-Einträge vollständig und aktuell sein.

10. Von der Quelle zur Autorität

Die Autorität einer Entität entsteht durch Quellenkonvergenz.

Wenn Wikipedia, Wikidata und DBpedia denselben Fakt bestätigen, steigt die Wahrscheinlichkeit, dass dieser Fakt im Knowledge Graph erscheint.

Diese Bestätigung über mehrere Ebenen ist die semantische Entsprechung von „E-E-A-T" – Erfahrung, Expertise, Autorität und Vertrauen – nur diesmal auf Datenebene.

In diesem Sinne sind Wikipedia und Wikidata nicht Orte der Werbung, sondern Orte der Validierung.

Sie bestimmen, ob ein Thema, eine Organisation oder ein Autor als seriös, konsistent und relevant gilt.

11. Fazit – Drei Quellen, ein semantisches Rückgrat

Wikipedia, Wikidata und DBpedia bilden gemeinsam die Grundstruktur des digitalen Wissens.

Ohne sie gäbe es keinen Knowledge Graph, keine präzise Suche und keine semantische Verbindung zwischen Konzepten.

Wikipedia liefert die narrative Oberfläche,

Wikidata die logische Tiefe,

DBpedia die technische Verbindung zur restlichen Wissenswelt.

Für SEO im semantischen Zeitalter bedeutet das:

Wer in diesen Schichten kohärent erscheint, schafft die Voraussetzungen, von Suchmaschinen verstanden, nicht nur gefunden zu werden.

Der Weg zu semantischer Sichtbarkeit führt nicht über mehr Keywords, sondern über präzise Identität und stabile Datenquellen.

Über den Autor

Marcus A. Volz ist Wirtschaftswissenschaftler, Linguist und Berater für semantische SEO. Er analysiert, wie Suchmaschinen Bedeutung verstehen und wie Marken durch semantische Klarheit sichtbar werden. Als Gründer von eLengua verbindet er ökonomisches Denken mit linguistischer Präzision, um Unternehmen im Zeitalter der KI-Suche strategisch zu positionieren. Sein Fokus liegt auf Entity SEO, semantischer Architektur und der Optimierung von Markenidentitäten in generativen Systemen.

Häufig gestellte Fragen (FAQ)

Was sind die Hauptdatenquellen des Google Knowledge Graph?

Die drei wichtigsten Quellen sind Wikipedia (narrative Texte), Wikidata (strukturierte Daten in Tripelform) und DBpedia (semantische Vernetzung im RDF-Format). Zusammen bilden sie die Grundlage für Googles Verständnis von Entitäten und deren Beziehungen.

Wie unterscheiden sich Wikipedia, Wikidata und DBpedia?

Wikipedia liefert sprachliche Beschreibungen für Menschen. Wikidata strukturiert diese Informationen in maschinenlesbare Tripel mit eindeutigen Q-IDs. DBpedia übersetzt Wikipedia-Inhalte automatisch in RDF-Format und verknüpft sie mit anderen semantischen Datenbanken.

Was ist eine Wikidata Q-ID?

Eine Q-ID ist eine eindeutige, sprachunabhängige Kennung für jede Entität in Wikidata (z. B. Q937 für Galileo Galilei). Sie ermöglicht die präzise Identifikation über alle Sprachversionen hinweg und verhindert Verwechslungen bei gleichnamigen Begriffen.

Wie führt Google Daten aus verschiedenen Quellen zusammen?

Google nutzt Wissensfusion: Wikipedia-Seiten werden mit Wikidata-Q-IDs verknüpft, DBpedia erzeugt korrespondierende URIs. Informationen werden validiert, indem mehrere unabhängige Quellen verglichen werden. Nur bestätigte Fakten gelangen in den Knowledge Graph.

Warum ist Konsistenz über Wikipedia, Wikidata und DBpedia wichtig für SEO?

Konsistenz über alle drei Ebenen signalisiert Vertrauenswürdigkeit. Wenn Name, Daten und Beziehungen überall übereinstimmen, wird die Entität als stabil und autoritativ eingestuft. Dies erhöht die Sichtbarkeit in Knowledge Panels und generativen Antworten.

Welche Rolle spielt DBpedia heute noch?

Während Wikidata DBpedia als Hauptquelle weitgehend abgelöst hat, bleibt DBpedia wichtig für die Vernetzung mit Legacy-Systemen und spezialisierten Fachdatenbanken. Sie dient als Brückentechnologie zwischen verschiedenen Linked-Open-Data-Projekten.

Wie kann ich meine Marke in Wikidata eintragen?

Erstelle zunächst einen Wikipedia-Artikel (sofern die Relevanzkriterien erfüllt sind). Anschließend kannst du einen Wikidata-Eintrag anlegen mit eindeutigen Properties, Quellen und sameAs-Verknüpfungen zur offiziellen Website. Pflege den Eintrag mehrsprachig und halte ihn aktuell.

Was sind sameAs-Verknüpfungen und warum sind sie wichtig?

sameAs-Verknüpfungen im Schema.org-Markup zeigen Google, dass verschiedene URIs dieselbe Entität beschreiben. Verweise auf Wikidata- und DBpedia-URIs stärken die semantische Identität und helfen bei der Zuordnung zu bestehenden Knowledge-Graph-Einträgen.