Zusammenfassung

Ähnlichkeitsmetriken sind das Herzstück moderner Such- und Empfehlungssysteme. Sie messen Abstände und Richtungen zwischen Vektoren und machen damit Bedeutungsnähe quantifizierbar. Dieser Artikel erklärt, wie Cosine Similarity, Euclidean Distance, Manhattan Distance und Dot Product funktionieren, wo ihre Stärken und Grenzen liegen und warum semantisches SEO auf diesen mathematischen Verfahren aufbaut. Relevanz wird zur Distanz – und Nähe zum neuen Maßstab für Sichtbarkeit.

Ähnlichkeitsmetriken – Wie Maschinen Bedeutung vergleichen

Bedeutung als Distanz

1. Warum Ähnlichkeit messbar sein muss

In der Vektorsuche steht jedes Wort oder jeder Satz als Punkt in einem mehrdimensionalen Raum. Damit Maschinen entscheiden können, welche Inhalte semantisch zueinanderpassen, müssen sie Abstände zwischen diesen Punkten messen. Je kleiner der Abstand, desto ähnlicher die Bedeutung.

Diese Nähe ist keine Zufälligkeit, sondern das Ergebnis von Trainingsprozessen, in denen Modelle wie Word2Vec oder BERT gelernt haben, welche sprachlichen Muster ähnliche Kontexte teilen.

In der Praxis wird diese „Ähnlichkeit" zum Maßstab für Relevanz: Eine Suchmaschine zeigt nicht mehr nur Dokumente, die denselben Begriff enthalten, sondern solche, deren Vektoren im Bedeutungsraum nahe beieinanderliegen.

2. Mathematische Grundlagen

Ein Vektor beschreibt die Position eines Wortes oder Satzes in einem Raum mit vielen Dimensionen – meist zwischen 100 und 1.000. Jede Dimension steht für ein semantisches Merkmal: grammatikalische, thematische oder emotionale Eigenschaften.

Um Ähnlichkeit zu messen, wird der Abstand zweier Vektoren berechnet. Dabei spielen zwei Aspekte eine Rolle:

Richtung: Gibt an, in welche semantische Richtung ein Begriff zeigt (z. B. thematische Nähe).

Distanz: Beschreibt, wie stark sich zwei Begriffe unterscheiden.

Zwei Vektoren, die in dieselbe Richtung zeigen, aber unterschiedlich lang sind, drücken ähnliche Bedeutungen mit unterschiedlicher Intensität aus.

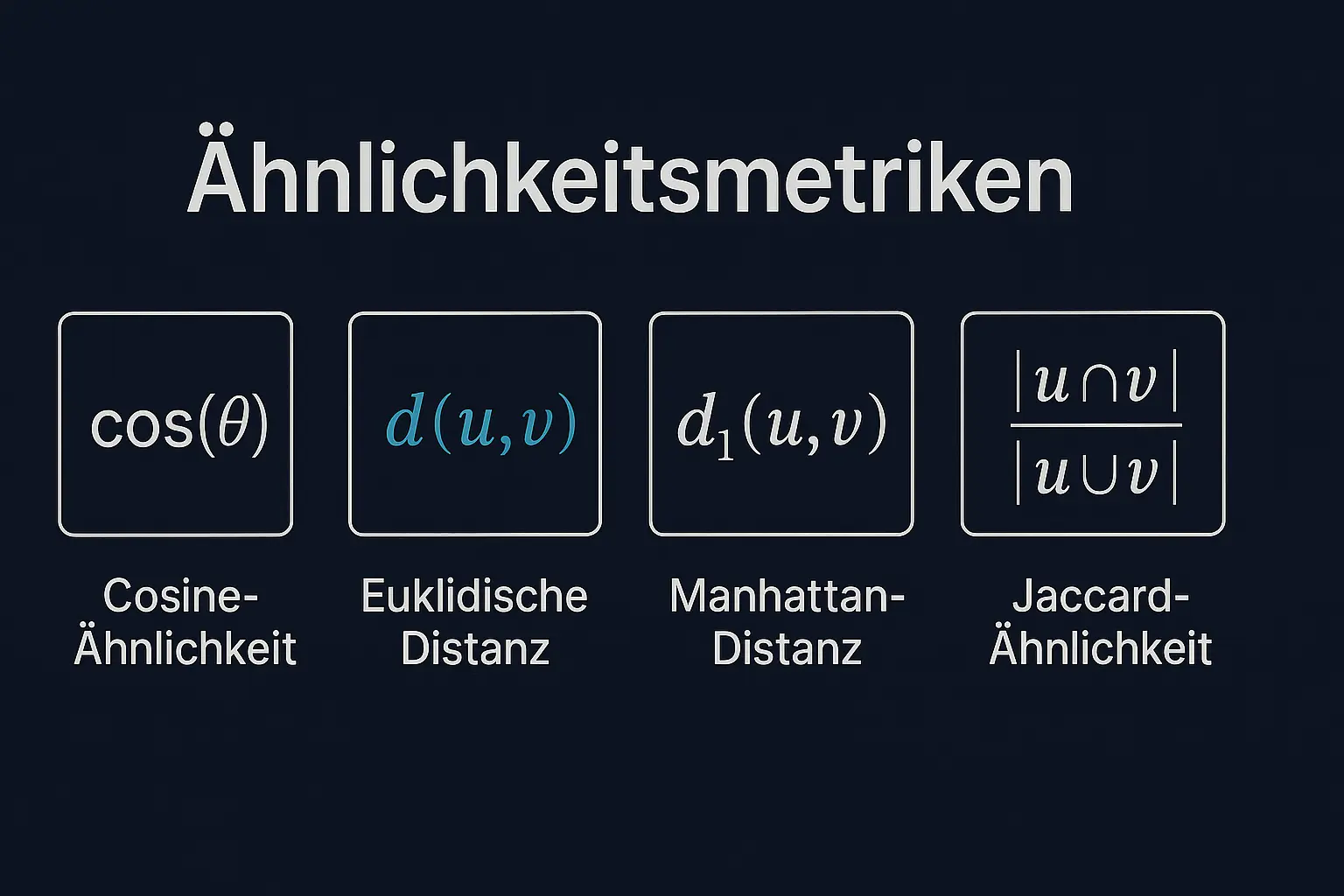

3. Die wichtigsten Ähnlichkeitsmetriken

3.1 Cosine Similarity

Die Cosine Similarity ist die am häufigsten verwendete Metrik in der semantischen Suche. Sie berechnet den Winkel zwischen zwei Vektoren. Ein Winkel von 0 Grad bedeutet, dass beide in dieselbe Richtung zeigen – ihre Bedeutung ist nahezu identisch. Ein Winkel von 90 Grad steht für völlige Unabhängigkeit, 180 Grad für Gegensätze.

Vorteil: Sie ignoriert die Länge der Vektoren und konzentriert sich auf die Richtung. Damit misst sie reine Bedeutungsähnlichkeit, unabhängig davon, wie häufig ein Begriff vorkommt. Suchmaschinen wie Google oder Perplexity nutzen diese Methode, um den „semantischen Kern" einer Anfrage zu erfassen.

3.2 Euclidean Distance

Die euklidische Distanz ist das klassische Maß für Abstand: die Luftlinie zwischen zwei Punkten. In der Vektorsuche zeigt sie, wie weit zwei Bedeutungen tatsächlich voneinander entfernt liegen – sowohl in Richtung als auch in Stärke.

Diese Metrik eignet sich gut für Clusteranalysen, hat aber Nachteile bei sehr hochdimensionalen Räumen: Abstände verlieren dort an Aussagekraft, weil alle Punkte scheinbar gleich weit voneinander entfernt sind (das sogenannte „Curse of Dimensionality").

Trotzdem bleibt die euklidische Distanz ein intuitives Maß: Wenn zwei Dokumente viele gemeinsame Begriffe oder Themen haben, liegen sie im Raum dichter beieinander.

3.3 Manhattan Distance

Die Manhattan Distance misst den Abstand entlang der Achsen, nicht diagonal. Der Name stammt vom Schachbrettmuster der Straßen in Manhattan: Man kann sich nur geradeaus und im rechten Winkel bewegen.

In der semantischen Analyse wird sie seltener verwendet, aber in speziellen Szenarien nützlich – etwa bei diskreten oder kategorischen Merkmalen. Sie bietet Robustheit gegenüber Ausreißern und eignet sich für strukturierte Datensätze, etwa bei tabellarischen Merkmalen oder Sentiment-Clustern.

3.4 Dot Product (Skalarprodukt)

Das Skalarprodukt berechnet die Projektion eines Vektors auf einen anderen. Es bewertet nicht den Abstand, sondern wie stark zwei Bedeutungen in dieselbe Richtung weisen. In neuronalen Modellen dient das Skalarprodukt oft als Grundlage für Relevanzbewertungen, weil es einfach und rechenökonomisch ist.

Während die Cosine Similarity Winkel vergleicht, misst das Skalarprodukt die tatsächliche Überlappung der Vektoren – es ist empfindlicher für Unterschiede in der Intensität. Große Sprachmodelle wie GPT, Gemini oder Claude nutzen Varianten des Skalarprodukts in ihren Attention-Mechanismen, um kontextuell passende Informationen zu gewichten.

3.5 Jaccard Similarity und weitere Varianten

Neben geometrischen Metriken gibt es auch symbolische Maße wie die Jaccard Similarity. Sie berechnet die Schnittmenge zwischen zwei Mengen – also den Anteil gemeinsamer Wörter oder Merkmale. Diese Methode spielt eine Rolle in hybriden Systemen, die klassische Textmerkmale mit semantischen Signalen kombinieren.

Weitere Varianten sind die Hamming Distance (bei binären Daten) und Soft Cosine Similarity, die semantische Wortähnlichkeiten zusätzlich gewichtet. Solche erweiterten Ansätze verbessern das Verständnis von Textbedeutungen, wenn mehrere Ebenen – Syntax, Semantik, Kontext – gleichzeitig berücksichtigt werden.

4. Vergleich und Interpretation

| Metrik | Bewertet | Vorteil | Nachteil | Typische Anwendung |

|---|---|---|---|---|

| Cosine Similarity | Winkelrichtung | Skalenunabhängig, semantisch präzise | Keine Intensitätsbewertung | Semantische Suche, Textvergleich |

| Euclidean Distance | Direkten Abstand | Intuitiv, visuell interpretierbar | Unzuverlässig in hohen Dimensionen | Clustering, Klassifikation |

| Manhattan Distance | Achsendifferenzen | Robust gegen Ausreißer | Weniger präzise für Bedeutungen | Strukturierte Daten |

| Dot Product | Projektion | Effizient, modellkompatibel | Skalenabhängig | Neuronale Netze, Attention-Mechanismen |

| Jaccard Similarity | Schnittmenge | Einfach, transparent | Nur symbolisch | Hybrid-Systeme, Keyword-Suche |

Diese Übersicht verdeutlicht: Keine Metrik ist universell. In der Praxis werden häufig mehrere kombiniert, um Präzision und Kontexttiefe zu erreichen.

5. Konkrete Beispiele und Anwendungsfälle

Beispiel: Wortähnlichkeiten in der Praxis

Bei der Cosine Similarity zwischen Wortvektoren ergeben sich typischerweise folgende Werte:

- „König" und „Königin": Cosine Similarity ~0.85–0.95 (sehr ähnlich, gleicher Kontext)

- „König" und „Monarchie": ~0.65–0.75 (thematisch verwandt)

- „König" und „Apfel": ~0.15–0.25 (kaum semantische Beziehung)

- „König" und „Stuhl": ~0.1–0.2 (keine relevante Verbindung)

Diese Werte entstehen durch Training auf großen Textkorpora, in denen das Modell gelernt hat, welche Wörter in ähnlichen Zusammenhängen erscheinen.

Beispiel: Suchmaschinen-Anwendung

Ein Nutzer sucht nach „Texterstellung für Online-Shops". Die Suchmaschine wandelt diese Anfrage in einen Vektor um und vergleicht ihn mit gespeicherten Dokumentvektoren:

- Dokument A: „Kategorietexte schreiben lassen" → Cosine Similarity: 0.87

- Dokument B: „Content-Marketing-Strategien" → Cosine Similarity: 0.71

- Dokument C: „Technische SEO-Optimierung" → Cosine Similarity: 0.43

Obwohl Dokument A andere Wörter verwendet, wird es aufgrund der höchsten semantischen Nähe zuerst angezeigt.

Diese praktischen Beispiele zeigen, wie Ähnlichkeitsmetriken die Grundlage für intelligente Suchsysteme bilden, die Bedeutung über exakte Wortübereinstimmungen stellen.

6. Bedeutung für semantisches SEO

Ähnlichkeitsmetriken haben eine zentrale Rolle in der modernen Suchmaschinenoptimierung. Sie bestimmen, welche Inhalte aus Sicht der Suchmaschine „verwandt" sind – selbst wenn sie unterschiedliche Wörter verwenden.

Google nutzt diese Prinzipien etwa bei der Bewertung semantischer Cluster. Wenn eine Seite über „Texterstellung", „Leseführung" und „Tonalität" spricht, erkennt das System über Vektorähnlichkeiten, dass sie thematisch zusammengehören.

Dadurch wird nicht mehr nur die Häufigkeit eines Begriffs relevant, sondern dessen Beziehung zu anderen Bedeutungsfeldern. Inhalte, die innerhalb eines konsistenten semantischen Raums stehen, gelten als kohärenter und erhalten höhere Sichtbarkeit.

Für die Content-Strategie bedeutet das:

- Themen sollten semantisch vernetzt sein

- Begriffe mit ähnlicher Bedeutung müssen natürlich eingebettet werden

- Keyword-Dichte verliert an Bedeutung; entscheidend ist die semantische Kohärenz

So wird Relevanz zu einem Produkt aus Bedeutung, Kontext und Nähe – nicht mehr aus Wortzählung.

7. Grenzen und Herausforderungen

So mächtig Ähnlichkeitsmetriken sind, sie haben auch Grenzen. In sehr hohen Dimensionen wird Distanz schwer interpretierbar – viele Punkte scheinen gleich weit voneinander entfernt. Zudem spiegeln die Vektoren nur das, was die Trainingsdaten enthalten. Wenn diese kulturell, sprachlich oder thematisch einseitig sind, entstehen Verzerrungen.

Ein weiteres Problem liegt in der Erklärbarkeit: Maschinen wissen, dass zwei Texte ähnlich sind, können aber nicht angeben, warum. Für SEO-Analysen bedeutet das, dass Relevanz zunehmend datengetrieben, aber weniger nachvollziehbar wird.

Das Curse of Dimensionality: In Räumen mit mehr als 1.000 Dimensionen verlieren Distanzmetriken an Unterscheidungskraft. Der Abstand zwischen dem nächsten und dem entferntesten Punkt wird relativ gesehen immer kleiner. Deshalb setzen moderne Systeme auf Dimensionsreduktion oder spezialisierte Algorithmen.

Viele Systeme lösen diese Probleme, indem sie Hybridmodelle einsetzen: Klassische statistische Verfahren werden mit semantischen Metriken kombiniert. So bleibt die Berechnung effizient und gleichzeitig interpretierbar.

8. Fazit – Nähe als neues Maß für Relevanz

Ähnlichkeitsmetriken sind die Brücke zwischen mathematischer Struktur und sprachlicher Bedeutung. Sie machen Relevanz quantifizierbar, indem sie Nähe messen – nicht Gleichheit.

In der semantischen Indexierung ersetzt Ähnlichkeit die reine Wortidentität. Für SEO und Content-Strategie bedeutet das eine fundamentale Veränderung: Erfolg entsteht nicht mehr durch Keyword-Optimierung, sondern durch die Fähigkeit, Bedeutungsräume zu gestalten.

Wer Inhalte schafft, die inhaltlich zusammenhängen, kontextuell anschlussfähig sind und eine klare semantische Struktur bilden, wird in der neuen Logik der Suche sichtbar – dort, wo Relevanz als Distanz gemessen wird.

Über den Autor

Marcus A. Volz ist Linguist und Spezialist für semantische KI-Systeme bei eLengua. Er analysiert, wie Suchmaschinen Bedeutung verstehen – von Vektorräumen über Embeddings bis zur semantischen Indexierung. Seine Arbeit verbindet theoretische Sprachwissenschaft mit praktischer Anwendung in SEO und Content-Optimierung.

Häufig gestellte Fragen (FAQ)

Warum ist Ähnlichkeit in der Vektorsuche messbar?

In der Vektorsuche steht jedes Wort oder jeder Satz als Punkt in einem mehrdimensionalen Raum. Ähnlichkeit wird durch den Abstand zwischen diesen Punkten gemessen: Je kleiner der Abstand, desto ähnlicher die Bedeutung. Diese Nähe entsteht durch Trainingsprozesse, in denen Modelle lernen, welche sprachlichen Muster ähnliche Kontexte teilen.

Was ist Cosine Similarity und warum wird sie am häufigsten verwendet?

Cosine Similarity berechnet den Winkel zwischen zwei Vektoren. Ein Winkel von 0° bedeutet identische Bedeutung, 90° völlige Unabhängigkeit, 180° Gegensätze. Sie ignoriert die Länge der Vektoren und konzentriert sich auf die Richtung, wodurch sie reine Bedeutungsähnlichkeit misst – unabhängig von der Worthäufigkeit.

Wie unterscheidet sich Euclidean Distance von Cosine Similarity?

Euclidean Distance misst die direkte Luftlinie zwischen zwei Punkten und berücksichtigt sowohl Richtung als auch Stärke. Cosine Similarity bewertet nur die Richtung. Euclidean Distance eignet sich gut für Clusteranalysen, verliert aber in hochdimensionalen Räumen an Aussagekraft (Curse of Dimensionality).

Wann verwendet man Manhattan Distance?

Manhattan Distance misst den Abstand entlang der Achsen (wie Straßen in Manhattan: nur geradeaus und im rechten Winkel). Sie wird bei diskreten oder kategorischen Merkmalen verwendet und ist robust gegenüber Ausreißern – etwa bei tabellarischen Daten oder Sentiment-Clustern.

Was ist der Unterschied zwischen Dot Product und Cosine Similarity?

Das Dot Product (Skalarprodukt) berechnet die Projektion eines Vektors auf einen anderen und misst die tatsächliche Überlappung – es ist empfindlicher für Unterschiede in der Intensität. Cosine Similarity normalisiert diese Werte und vergleicht nur Winkel. Große Sprachmodelle nutzen Varianten des Skalarprodukts in ihren Attention-Mechanismen.

Wie beeinflussen Ähnlichkeitsmetriken semantisches SEO?

Ähnlichkeitsmetriken bestimmen, welche Inhalte aus Sicht der Suchmaschine verwandt sind – selbst bei unterschiedlichen Wörtern. Google nutzt Vektorähnlichkeiten, um semantische Cluster zu bewerten. Erfolgreiche Content-Strategie erfordert semantisch vernetzte Themen, natürlich eingebettete Begriffe und semantische Kohärenz statt reiner Keyword-Dichte.

Welche Grenzen haben Ähnlichkeitsmetriken?

In hochdimensionalen Räumen wird Distanz schwer interpretierbar (Curse of Dimensionality). Vektoren spiegeln nur Trainingsdaten wider, wodurch kulturelle oder sprachliche Verzerrungen entstehen können. Zudem fehlt Erklärbarkeit – Maschinen erkennen Ähnlichkeit, können aber nicht begründen warum. Hybridmodelle kombinieren daher oft klassische und semantische Verfahren.

Gibt es praktische Beispiele für Ähnlichkeitswerte?

Bei Cosine Similarity haben semantisch eng verwandte Begriffe wie „König" und „Königin" typischerweise Werte um 0.85–0.95 (sehr ähnlich). „König" und „Monarchie" liegen bei etwa 0.65–0.75 (thematisch verwandt). „König" und „Stuhl" erreichen nur 0.1–0.2 (kaum Beziehung). Diese Werte entstehen durch das Training auf großen Textkorpora.